b. Cartographie des enjeux

enjeux travail

La situation actuelle

Il existe des risques spécifiques associés au déploiement des SIA en entreprise, sans pour autant que des politiques de maîtrise des risques à la hauteur soient déployées :

- Responsabilité civile de la ligne managériale en cas de dommages causés par un SIA déployé au sein de l’entreprise

- Risques de piratage de données personnelles (salariés et/ou clients)

- Risques opérationnels liés la perte d’expertise dans la mesure où un développement du SIA sans implication forte des professionnels de l’entreprise (contrôle de cohérence des résultats, entraînement, etc.) aboutit souvent à l’abandon progressif de l’expertise maison à celle supposée supérieure de la machine…

- Risques dits en « cascade » lors d’une intégration complexe et question de surveillance sur toute la chaîne opérationnelle.

- Risques réputationnels (cf. « hallucinations » i.e. réponses aberrantes susceptibles d’induire en erreur les utilisateurs). Ce risque est plus ou moins sensible selon les contextes/secteurs/finalités de l'outil.

Solutionnisme technologique et invisibilisation du facteur humain :

- Perte de la notion de la tâche « complexe » : une tâche est devenue « en apparence » simple grâce à tout le processus d’apprentissage et à l’intégration de plusieurs savoir-faire du salarié / de l'exécutant(e), mais cette tâche est en fait complexe et requiert un degré de reconnaissance et de compréhension de son environnement.

- La remise en cause des métiers, voire de l’activité de l’entreprise qui, du jour au lendemain, peut se trouver en concurrence avec une IA. Cela peut générer une défiance à tous les niveaux de l’entreprise (des fonctions support aux professionnels de terrain).

- Risques RH associés : RPS, perte d’expertise, plans sociaux « sauvages » (on se souvient du scandale Onclusive en France en 2023).

Pourquoi aller vers le dialogue social sur cet enjeu ?

Le « secret industriel » souvent mis en avant pour justifier une absence de dialogue social digne de ce nom, s’avère au final contreproductif dans la mesure où laisser les professionnels de l’entreprise en marge du processus de mise en œuvre du SIA expose l’entreprise à un risque accru d’échec pour toutes les raisons évoquées ci-dessus.

L’enjeu majeur ici est de remettre le facteur humain au cœur du processus de déploiement des SIA en entreprise :

- En amont : s’assurer que le SIA répond aux besoins réels internes/externes grâce à l’implication des salariés et de leurs représentants.

- Pour qualifier les données d’entraînement du SIA et se prémunir des « hallucinations »

- Formation des acteurs et appropriation de l’outil via une délibération collective organisée.

- Après : organiser/financer les reconversions professionnelles internes/externes des salariés dont le métier est directement impacté par l'outil.

Comment s’y prendre ?

Voir la partie 2 de ce document.

enjeux environnementaux

La situation actuelle

Les impacts environnementaux liés au développement des SIA dépendent d’une multiplicité de facteurs, ce qui rend les évaluations difficiles. Il existe des impacts positifs liés à l’usage de l’IA, par exemple en agriculture ou pour la production d’énergie. Ceci étant, il est aujourd’hui certain que le développement massif de l’IA est également dommageable en termes environnementaux. La problématique est aujourd’hui clairement posée au plan international et alimente les souhaits de disposer d’une IA frugale.

Quelques illustrations des impacts négatifs :

Énergivore en termes de consommation électrique : l’entrainement des SIA suppose l’injection de données massives et de grandes capacités de calcul. Ces opérations sont réalisées au sein de data centers qui sont de très gros consommateurs d’énergie. Cette consommation élevée d’énergie peut s’accompagner d’un bilan carbone plus ou moins négatif en regard du mix énergétique du pays dans lequel est situé le data center.

Consommatrice de minerais : la fabrication des composants électroniques nécessaires (processeurs, puces électroniques) conduit à l’extraction intensive de métaux rares, source de dommages environnementaux dans les zones d’extraction. L’utilisation de ces ressources pour l’IA met cette dernière en concurrence avec d’autres besoins, notamment ceux liés à la transition énergétique.

Productrice de déchets électroniques (terminaux, serveurs devenus obsolètes) : ce qui pose la question difficile du recyclage des déchets électroniques

Grande consommatrice de ressources en eau : notamment en regard du besoin de refroidissement des indispensables data centers.

Pourquoi aller vers le dialogue social sur cet enjeu ?

Les impacts environnementaux négatifs de l’IA justifient que ces variables soient prises en compte avant d’investir, a fortiori massivement, dans des systèmes d’IA. Il s’agit ainsi de véritablement questionner le bien-fondé du recours à l’IA et donc son utilité réelle en regard d’une analyse coûts/avantages globale.

Une des possibilités dans cette perspective est de questionner les coûts réels de la mise en place de l’IA au-delà de l’acquisition de telle ou telle solution logicielle, notamment en ce qui concerne les hardwares, les installations nécessaires, etc.

En termes de procédures, depuis la loi du 22 août 2021, le CSE dispose d’un droit à l'information/consultation sur les conséquences environnementales d’un ensemble de mesures prises par l’employeur, dont l’introduction de nouvelles technologies (article L. 2312-8 III. Code du travail).

Par ailleurs, la loi PACTE, promulguée en 2019, contraint les entreprises à prendre en compte les enjeux environnementaux et sociaux de leurs activités. Même si les obligations légales varient en fonction de la taille de l’entreprise, toutes sont concernées en termes d’image, mais aussi en cas de sous-traitance pour le compte d’une grande entreprise. Avec le déploiement tous azimuts de l’IA, la question de l’impact environnemental de cette technologie doit être posée dans le cadre du dialogue social sur la politique RSE globale de l’entreprise.

Des ressources pour aller plus loin et comprendre

Pour la science/INRIA, Le numérique est-il un progrès durable ? N° 546, avril 2023

CESE : quels effets l’intelligence artificielle (IA) peut-elle avoir sur l’environnement ? (saisine pour étude 2024)

AFNOR Spec, Référentiel général pour l’IA frugale, 2024

enjeux politique générale gouvernance

La situation actuelle ?

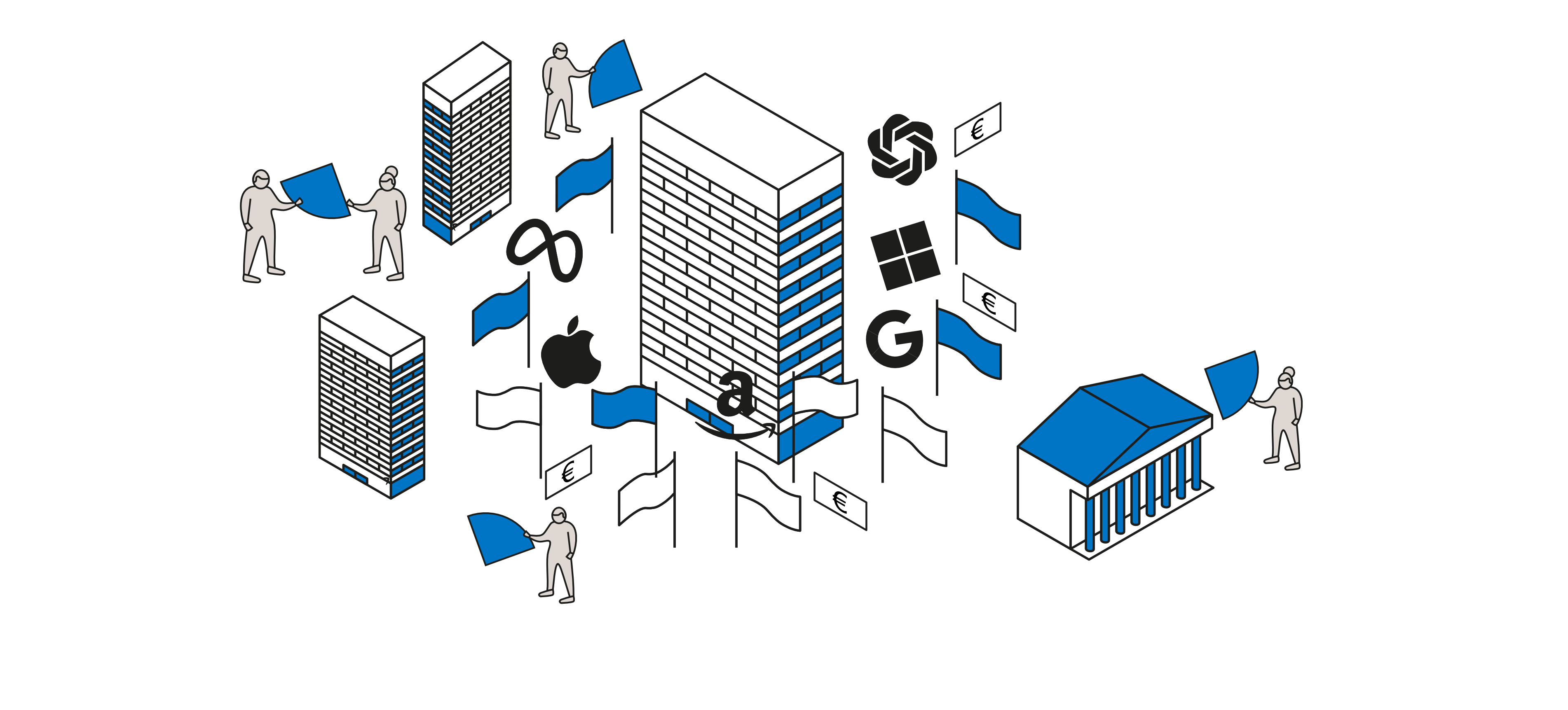

Si l'on se centre sur les entreprises, les enjeux de gouvernance peuvent être abordés sous l’angle de la double gouvernance technique et opérationnelle du système d’intelligence artificielle et des conséquences qui vont en découler en matière d’indépendance, de pouvoir, de souveraineté et d’autonomie. Quand l’entreprise garde la main et sur la gouvernance technique (c’est elle qui fait la technologie, c’est elle qui l’adapte sur la base d’un modèle open source, c’est elle qui l’entraîne sur la base de ses données propres) et sur la gouvernance opérationnelle (le projet répond aux besoins des utilisateurs finaux, il soutient les processus métiers, c’est l’entreprise qui administrera le système d’Intelligence artificielle, plutôt que de le confier par exemple à de l’info gérance), alors elle sera plus en capacité de garder la maîtrise de l’outil, de ses finalités, et de ses impacts.

Dans la plupart des cas, l’entreprise se situera dans une situation intermédiaire, voire, dans certains cas, inverse. Avec l’IA, et en particulier l’IAG (et les impacts sur les tâches « cognitives »), les risques en matière de perte de pouvoir et de contrôle sont démultipliés, en particulier pour les TPE-PME :

- Risques de dépendance au savoir technologique des experts, de dissymétrie entre le prestataire et le requérant ;

- Risques de capture des données (avec tous les enjeux éthiques, de concentration du pouvoir économique, de propriété intellectuelle, de souveraineté qui en découlent). Plus les choses convergent vers les GAFAM, plus la gouvernance sera réduite à un modèle élitiste, centralisé, loin de représenter la totalité des gouvernances autour de la production de la donnée !

- Risques de capture du savoir-faire de l’entreprise : l’IA vient offrir des services, alléger des fonctions répétitives, un peu basiques. Mais in fine, l’IA peut aussi capter l’expertise, quand le SIA est en mesure de capter les pratiques professionnelles, de se nourrir de l’expertise, des modes de travail, etc. Le problème est particulièrement aigu pour les professions libérales, pour lesquelles l’indépendance, la déontologie et le rapport au savoir revêtent une importance cruciale.

- Les vastes quantités de données nécessaires pour entraîner les modèles posent des problèmes de confidentialité, de propriété intellectuelle.

- Sans oublier évidemment les risques de cybersécurité, les failles de sécurité et les intrusions, la protection de la vie privée, les risques juridiques et réputationnels.

Pourquoi aller vers le dialogue social sur cet enjeu?

De nombreux cas d’usage partagés durant le projet DIALIA ont montré que le juste milieu entre la réflexion sur l’introduction de l’outil et les démarches « techno-solutionnistes » est rare.

Les outils proposés dans la seconde partie du livrable visent justement à permettre de sortir de cette logique « top down » des projets, de partir de l’organisation, des besoins des métiers, de s’interroger sur les conditions que l’outil doit remplir plutôt que l’inverse. Puisque c’est d’abord au travers de la transformation des activités, des qualifications, des organisations, des manières de travailler que la valeur se crée dans les organisations, le dialogue social doit aussi permettre un partage équitable des gains de productivité potentiellement permis par l’IA.

Au-delà, il faut admettre que l’utilisation des données, la transparence des algorithmes et plus globalement de l’IA impliquent une multiplicité de parties prenantes : fournisseurs, prestataires, clients, usagers, entreprises, plateformes, etc., et qu’un nouveau type de dialogue, organisé entre parties prenantes, peut contribuer à rééquilibrer les forces, que ce soit au sein de l'entreprise, de l’administration, entre l’entreprise ou une administration et un éditeur, au sein d’une filière économique, entre par exemple les petites et les grandes entreprises, donneurs d’ordres et sous-traitants.

Des ressources pour aller plus loin et comprendre

Plusieurs notes permettant de comprendre les risques de souveraineté liés à l'IA générative ont récemment été publiées par Hub France IA , accessibles ici.

Enjeux réglementaires

La situation actuelle

La réglementation des SIA et de leurs impacts constitue aujourd’hui un enjeu fort au niveau de l’Union Européenne. Le continent s’est ainsi engagé dans une vaste entreprise de régulation des impacts de l’IA. Une régulation qui se construit néanmoins par strates successives, de sorte qu’il existe aujourd’hui divers textes contraignants permettant d’appréhender directement ou indirectement les impacts des SIA.

Parmi les réglementations indirectes les plus impactantes sur la mise en place et la mise en œuvre des systèmes d’IA, il y a le Règlement (UE) 2016/679 du Parlement européen et du Conseil du 27 avril 2016, Règlement Général sur la Protection des Données (RGPD)

Ce texte déjà ancien vise à définir des garanties afférentes à la protection des personnes physiques, y compris les salariés ou agents publics, s’agissant de la collecte et du traitement des données personnelles les concernant. Dans la mesure où les systèmes d’IA reposent sur l’usage et l’exploitation massifs de données, ce texte a donc une portée réglementaire forte à l’égard des SIA. L’article 22 du RGPD interdit ainsi de prendre une décision de façon 100 % automatisée dès lors que celle-ci a des effets juridiques à l’égard d’une personne. Une disposition valable notamment pour les outils de recrutement.

Par ailleurs, la directive relative à l’amélioration des conditions de travail via une plateforme numérique intéresse aussi les problématiques de gestion algorithmique des travailleurs. Objet d’un accord politique et déjà adopté par le Parlement Européen, ce texte entrera rapidement en vigueur. Il ne vise que les travailleurs des plateformes numériques et son champ d’application est donc limité. Il n’évoque pas explicitement l'IA, mais consacre une partie de ses dispositions à l’encadrement de la gestion par algorithme. Il encadre ainsi les systèmes automatisés de gestion des ressources humaines, ceux conduisant donc à prendre des décisions impactant directement les travailleurs. Pour ce faire, il affirme un certain nombre de droits au bénéfice des travailleurs : information sur l’utilisation de systèmes de surveillance ou de prise de décision automatisés, garanties afférentes à l’existence d’un contrôle humain sur les décisions automatisées, droit à l’explication des décisions automatisées et possibilités de contestation. Le champ d’application limité de ce texte motive actuellement des réflexions et des propositions pour l’adoption de nouvelles normes européennes relatives à la gestion algorithmique et applicables de manière générale.

Plus directement, l’actualité réglementaire a été marquée par l’adoption le 21 mai dernier par le Conseil de l’UE d’un texte majeur : la Règlementation européenne sur l’intelligence artificielle (AI Act) publié au JO de l’UE le 12 juillet 2024, il est entré en vigueur le 1er août 2024, mais entrera en application de manière échelonnée à partir du 2 février 2025. Il définit des règles impératives applicables dans tous les États de l’UE.

Ce texte majeur est une réglementation visant à encadrer la mise sur le marché et l’utilisation de systèmes d’IA. Il classe les SIA utilisés en matière d’emploi et de gestion des travailleurs (recrutement, évaluation, affectation des travailleurs, rupture des relations de travail) comme étant à « haut risque ». Ainsi, il définit et impose des obligations aux employeurs. Il prévoit en particulier qu’avant de mettre en service ou d'utiliser un système d'IA à haut risque sur le lieu de travail, les employeurs doivent en informer les représentants des travailleurs et les travailleurs concernés. Même si elle constitue un point d’appui utile, cette disposition est jugée insuffisante par le mouvement syndical européen pour permettre un dialogue social à la hauteur des enjeux. Enfin, le règlement emporte des obligations particulières à l’égard des fournisseurs de modèles d’IA à usage général, visant par là les grands modèles de langage type ChatGPT.

Pourquoi aller vers le dialogue social sur cet enjeu ?

Si certains des textes évoqués ci-dessus offrent des possibilités d’action par le biais du dialogue social, on peut observer que s’agissant du Règlement IA, ne sont prévues que peu de garanties au soutien d’un dialogue social approfondi lié à l’introduction et à la vie d’un système IA en organisation.

On notera cependant que l’article 88 du RGPD ouvre la possibilité aux Etats Membres de préciser voire de renforcer les protections offertes par le RGPD en matière de relations de travail par le biais de conventions collectives. Une option qui n’a pas été saisie en France à ce jour…

Par ailleurs, n’oublions pas que la réglementation européenne s’accompagne d’un dispositif d’amendes qui peut s’avérer rédhibitoire pour les contrevenants en cas de manquements répétés !

Des ressources pour aller plus loin et comprendre

Voir la partie 2 pour les leviers et les outils.

Voir aussi Vie Publique - Intelligence artificielle : le cadre juridique européen de l’IA en 6 questions - https://www.vie-publique.fr/questions-reponses/292157-intelligence-artificielle-le-cadre-juridique-europeen-en-6-questions

Enjeux données

La situation actuelle ?

L’apprentissage de l’IA (générative ou non) repose sur son entraînement, sur la qualité et la cohérence et l'absence de biais des données choisies pour l'apprentissage. Le type d’interaction, de biais, d’aide à la décision ou à la réalisation de tâches qu’un système d’IA aura une fois déployé seront intrinsèquement liés à la qualité et à la nature des jeux de données mobilisées.

Les données sont les ingrédients des algorithmes, les modèles calculés par les algorithmes utilisent des données en entrée pour renvoyer un résultat. De la centralité des données et des modèles découlent, du point de vue des impacts des systèmes d’intelligence artificielle dans le monde du travail et, a fortiori, pour le dialogue social, des enjeux structurants :

- La qualité des jeux de données doit s’apprécier tout au long du « cycle de vie » du système d’intelligence artificielle. La base d’apprentissage ne sera pas la même que la base de test (interne à l’entreprise), la base de vérification ne sera pas forcément la même que la base de test, etc.

- Les données utilisées dans les modèles ne sont jamais brutes, et sont le résultat d’un travail humain. Le travail de sélection, d’organisation, d’annotation, de préparation des données sous- jacent au développement de l’IA est très souvent permis par des travailleurs invisibles, souvent situés dans les pays du Sud, avec de mauvaises conditions de travail. En découlent des enjeux en matière de responsabilité sociale et environnementale, de devoir de vigilance, et de partage de la valeur le long de la chaîne de sous-traitance. De nombreux salariés ou agents, seront aussi garants, une fois le SIA déployé et adapté dans l’organisation, de la qualité du calibrage aux besoins métiers, et des boucles de rétroaction réalisées. Les usagers (dans le cas de l’administration), les clients (dans le cas d’une entreprise) peuvent aussi être mis à contribution. Ce travail contribue à la création de valeur attendue du système d’intelligence artificielle. En découlent des enjeux d’identification et de partage de la valeur, de responsabilité.

- Aucune IA n’est entrainée sur une base pouvant être considérée comme universelle, couvrant l’ensemble de l’internet humain. L’IA n’a pas accès à un pool illimité et exhaustif de connaissances. En découlent des enjeux de biais, de discrimination, de protection des droits fondamentaux.

- La taille de la base de données résulte avant tout de choix humains. Deux écoles s’affrontent en quelque sorte : la Shadock « Je prends tout le Web ! » et la frugale « Je vais tourner sur une base locale, sur un gros PC ». En résultent des enjeux de coûts d’entraînement, de quantité d’énergie consommée.

- Les données collectées et traitées sont potentiellement de nature très différentes : qualitatives, quantitatives, ouvertes, internes, individuelles, collectives, etc. Les systèmes d’intelligence artificielle utilisés en particulier dans le cadre de la gestion des ressources humaines reposent sur la collecte et le traitement d'une masse de données, dont beaucoup sont liées à une personne identifiable et considérées comme des «données à caractère personnel ». Mais des données collectées sur une personne peuvent aussi avoir des inférences sur une autre personne, un collectif, et toutes les données utilisées par les SIA ne seront pas considérées comme personnelles. En découlent des enjeux de qualification des données, de protection des droits fondamentaux, d’identification des protections associées aux différents types de données.

- Les modèles ont une capacité plus ou moins importante à fonctionner sur des jeux de données différents de ceux sur lesquels ils ont été entraînés. Quand les données d’entreprise (ou de l’administration) sont récupérées par le fournisseur de la solution (typiquement le cas d’OpenAI pour ChatGPT), la réutilisation de ces données expose potentiellement les données des entreprises. En résultent des enjeux de confidentialité, de secret des affaires, de propriété intellectuelle, etc.

- Les données sont actuellement massivement privatisées par les grandes plateformes. Le modèle d'IA qui en découlera sera forcément probabiliste, avec peu d'originalité. Par nature, ces grands modèles ne savent pas gérer les événements rares, « les cygnes noirs », les signaux faibles. Quand une IA est adaptée dans une entreprise, calibrée sur les données spécifiques à l'entreprise, elle est alors co-produite avec les acteurs de l'entreprise, impliquant un échantillon des différents métiers et fonctions de l'entreprise. Les managers ont un rôle essentiel à jouer dans cette phase de calibrage. Un enjeu majeur réside dans la capacité de créer des bases de données ouvertes qui peuvent être testées et réutilisées dans d'autres contextes. C'est à cette condition que l'on aura une garantie scientifique de la démarche d'apprentissage, une approche scientifique des grands modèles d'IA, notamment générative.

Pourquoi aller vers le dialogue social sur cet enjeu?

Du fait même que les systèmes d'intelligence artificielle sont amenés à remplacer des tâches, aider à la décision, s'interfacer avec l'organisation du travail, etc., et que la nature de ces interactions dépendra pour beaucoup des jeux de données mobilisés, tout au long du cycle de vie du système, le dialogue social ne peut qu'être amené à s'approprier la thématique des données. Qui est garant de l’apprentissage, qui supervise, qui est compétent, qui crée de la valeur, etc. ?

La place du dialogue social est d'autant plus importante que le RGPD et la loi européenne sur l'IA ouvrent certes de nombreuses potentialités d'action aux représentants du personnel (voir partie 2 du livrable), mais ils n'ont, fondamentalement, pas été conçus pour traiter des enjeux spécifiques au monde du travail. C'est d'ailleurs bien pour cela que l'article 88 du RGPD prévoit des règles plus spécifiques pour assurer la protection des droits et libertés en ce qui concerne le traitement des données à caractère personnel des employés dans le cadre des relations de travail !

Objets socio-techniques

La situation actuelle ?

Les SIA, a fortiori en regard de l’essor des IAG, font souvent figure de solutions magiques. Si l’on peut convenir des performances de plus en plus notables de ces systèmes dans tous les domaines, il faut cependant se défier de tout déterminisme technologique. L’introduction de SIA en organisation ne doit pas être fondée sur un solutionnisme technologique aveugle. Il s’agit par là de bien comprendre que toute technologie numérique impacte les organisations du travail autant que les organisations du travail en place impactent l’efficacité de telle ou telle solution. Les SIA influencent leur environnement (l’entreprise, ses parties prenantes internes dans leur diversité, les relations entre ces dernières, les conditions dans lesquelles elles agissent, etc.) autant qu’ils agissent en interaction avec ce dernier. Il est donc impossible de parier sur les apports positifs d’un SIA pour l’organisation sans prendre en compte pleinement cette dernière et ce qui la constitue. C’est d’autant plus le cas que les spécificités mêmes des SIA (évolutifs, pas nécessairement intelligibles quant à la manière dont ils produisent leurs résultats, pas nécessairement transparents non plus quant aux données qui les alimentent, etc.) suscitent des interrogations quant à leur fiabilité (biais, hallucinations, etc.) et plus globalement quant à leur valeur ajoutée réelle.

De tout ceci découlent des nécessités : s’assurer de l’utilité des SIA pour l’organisation cible, garantir la transparence quant aux SIA utilisés dans une organisation (l’introduction de couches logicielles IA est souvent invisible), assurer l’explicabilité des SIA en place, etc.

Pourquoi aller vers le dialogue social sur cet enjeu?

Répondre à ces nécessités suppose la mise en place , au sein de l’organisation et de manière volontariste, d’une technologie sociale, autrement dit d’un dialogue social adapté aux enjeux et spécificités des SIA et capable d’associer de manière itérative les différentes composantes de l’organisation (direction générale, lignes managériales, métiers, salariés et leurs représentants, etc.)

Comment s’y prendre ?

Voir la partie 2 de ce document.

Des ressources pour aller plus loin et comprendre

ANACT 10 questions sur la maîtrise des transformations numériques - https://www.anact.fr/10-questions-sur-la-maitrise-des-transformations-numeriques